Как сделать robots.txt для WordPress

Всем привет, сегодня я расскажу как сделать robots.txt для WordPress. Создание файла robots.txt необходимо в первую очередь для указания роботам поисковых систем, какие именно разделы вашего сайта робот может обходить и индексировать а какие нет.

Всем привет, сегодня я расскажу как сделать robots.txt для WordPress. Создание файла robots.txt необходимо в первую очередь для указания роботам поисковых систем, какие именно разделы вашего сайта робот может обходить и индексировать а какие нет.

По факту — этот служебный файл нужен для указания поисковым ботом, какие разделы сайта будут индексироваться в поисковых системах, а какие поисковый робот должен пропустить. Но, нужно понимать, что роботы поисковых систем могут проигнорировать запрещающую директиву и проиндексировать раздел. Тем не менее подобные случаи встречаются довольно редко.

Содержание статьи:

- Создание файла robots.txt

- Расшифровка файла robots.txt (директивы)

- Пример расширенного файла Robots.txt моего сайта

Robots.txt для WordPress – как сделать?

1. Создаем текстовый файл с названием robots в формате .txt. Создается обычным текстовым редактором.

2. Далее, внесите в этот файл следующую информацию:

User-agent: Yandex Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-comments Disallow: /wp-content/plugins Disallow: /wp-content/themes Disallow: /wp-content/cache Disallow: /wp-login.php Disallow: /wp-register.php Disallow: */trackback Disallow: */feed Disallow: /cgi-bin Disallow: /tmp/ Disallow: *?s= User-agent: * Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-comments Disallow: /wp-content/plugins Disallow: /wp-content/themes Disallow: /wp-content/cache Disallow: /wp-login.php Disallow: /wp-register.php Disallow: */trackback Disallow: */feed Disallow: /cgi-bin Disallow: /tmp/ Disallow: *?s= Host: site.com Sitemap: http://site.com/sitemap.xml

3. Замените в директиве Host: site.com (site.com) – на название вашего сайта.

4. Укажите в директиве Sitemap: полный путь к вашей карте сайта. URL-адрес может отличаться в зависимости от плагина который генерирует карту на вашем сайте.

5. Сохраните и загрузите файл robots.txt в корневую папку вашего сайта. Сделать это можно с помощью любого FTP-клиента.

6. Отлично, ваш файл готов и функционирует. Теперь, роботы поисковых систем перед обходом сайта, сначала будут обращаться к этому служебному файлу.

Расшифровка файла robots.txt (директивы)

Теперь, давайте разберемся в файле Robots.txt подробнее. Что и для чего мы внесли в файл robots.txt.

User-agent — директива, необходима для указания названия поискового робота. С помощью нее можно запретить или разрешить поисковым роботам посещать Ваш сайт. Например:

Запрещаем роботу Яндекса просматривать папку с кэшем:

User-agent: Yandex

Disallow: /wp-content/cache

Разрешаем роботу Bing просматривать папку themes (с темами сайта):

User-agent: bingbot

Allow: /wp-content/themes

Для того, чтобы наши правила действовали едино для всех поисковых систем. Используйте директиву: User-agent: *

Allow и Disallow — разрешающая и запрещающая директива. Примеры:

Разрешим боту Яндекса просматривать папку wp-admin:

User-agent: Yandex

Allow: /wp-admin

Запретим всем ботам просматривать папку wp-content:

User-agent: *

Disallow: /wp-content

В этом robots.txt не используется директива Allow, то что мы не запрещаем с помощью директивы Disallow — по умолчанию будет разрешено.

- Host — директива, нужна для того чтобы указать главное зеркало сайта, именно оно будет индексироваться роботом. Все стороннее не будет обходиться.

- Sitemap — тут, мы указываем путь к карте сайта. Обратите внимание, Sitemap очень важный инструмент для продвижении сайта! Ее наличие крайне необходимо, не забывайте об этом.

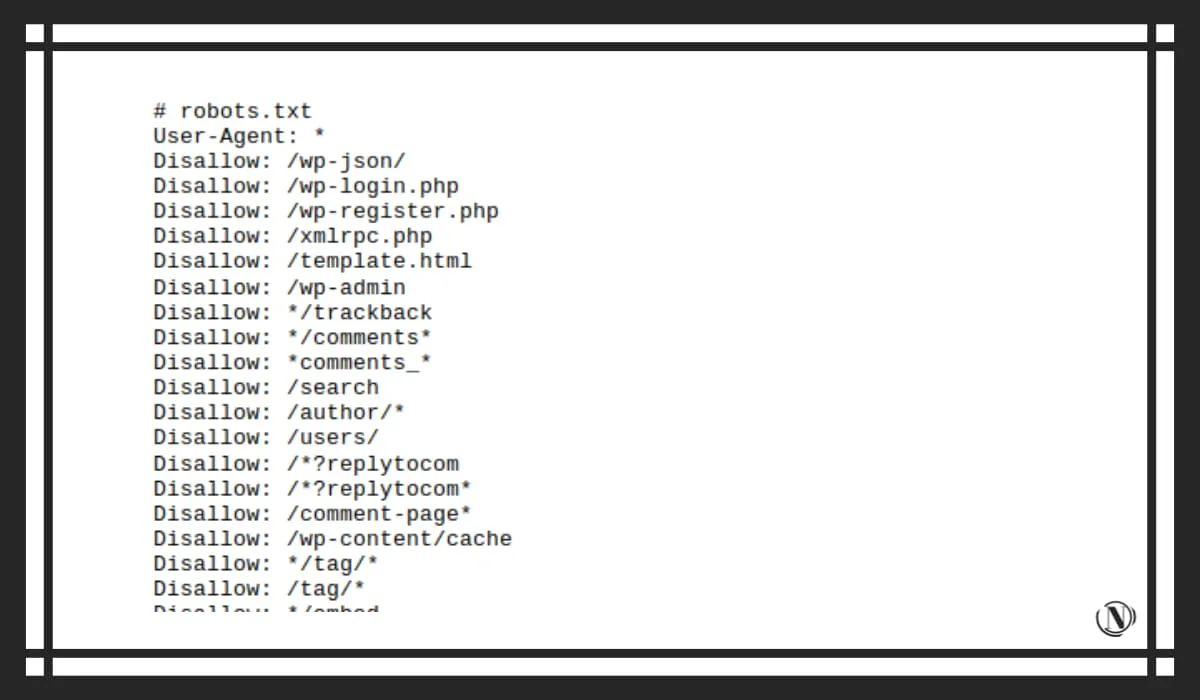

Пример расширенного файла Robots.txt моего сайта

Теперь, рассмотрим файл robots моего сайта. Обратите внимание, запрещающие или разрешающие директивы я правлю под свои нужны. Если вы решите воспользоваться моим примером, то обязательно просмотрите файл и удалите те директивы, которые вам не нужны.

Примем файла robots.txt этого сайта:

# robots.txt User-Agent: * Disallow: /wp-json/ #техническая информация Disallow: /wp-login.php #безопасность Disallow: /wp-register.php #безопасность Disallow: /xmlrpc.php #безопасность, файл WordPress API Disallow: /template.html #техническая информация Disallow: /wp-admin #безопасность Disallow: */trackback #дубли, комментариев Disallow: */comments* #дубли, комментариев Disallow: *comments_* #дубли, комментариев Disallow: /search #страницы результатов поиска на сайте Disallow: /author/* #страницы автора и пользователей Disallow: /users/ Disallow: /*?replytocom #сопливый индекс Disallow: /*?replytocom* Disallow: /comment-page* #страницы комментариев Disallow: /wp-content/cache #папка кеш Disallow: */tag/* #теги - если уместно Disallow: /tag/* Disallow: */embed$ #все встраивания Disallow: */?s=* #поиск Disallow: */?p=* #поиск Disallow: */?x=* #поиск Disallow: */?xs_review=* #страницы редактор записи, визуальный просмотр Disallow: /?page_id=* #страницы редактор страницы, визуальный просмотр Disallow: */feed #все фиды и rss каналы Disallow: */?feed Disallow: */rss Disallow: *.php #технические файлы Disallow: /ads.txt #технические страницы рекламных объявлений, если уместно Disallow: */amp #все страницы amp - если используете технологию, не запрещайте. Disallow: */amp? Disallow: */amp/ Disallow: */?amp* Disallow: */stylesheet #некоторые страницы стилей, которые вылезли Disallow: */stylesheet* Disallow: /?customize_changeset_uuid= #технические дубли плагина кеширования и сжатия Disallow: */?customize_changeset_uuid*customize_autosaved=on

#указываем ботам файлы, которые нужны для корректного отображения страниц сайта. Allow: /wp-content/uploads/ Allow: /wp-includes Allow: /wp-content Allow: */uploads Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif Allow: /wp-admin/admin-ajax.php

#разрешение для ботов просмотра папки с картинками User-agent: Googlebot-Image Allow: /wp-content/uploads/ User-agent: Yandex-Images Allow: /wp-content/uploads/ User-agent: Mail.Ru-Images Allow: /wp-content/uploads/ User-agent: ia_archiver-Images Allow: /wp-content/uploads/ User-agent: Bingbot-Images Allow: /wp-content/uploads/

#указываем главное зеркало и карту сайта Host: https://nicola.top Sitemap: https://nicola.top/sitemap_index.xml

Заключение

Я рассказал достаточно подробно, о том как создать robots.txt для WordPress. Обратите внимание, все внесенные изменения в этот файл, будут заметны спустя некоторое время. Наиболее полный обзор вы можете посмотреть в статье о как сделать robots.txt для сайта на различных CMS.

Редактируйте директивы в зависимости от ваших потребностей. Не нужно бездумно, вносить все подряд в этот служебный файл. Такое безответственное внесение изменений, может привести к выпадению и полному удалению важных страниц или разделов сайта из поиска. Надеюсь это руководство будет вам полезно, обязательно оставляйте комментарии с вопросами.

С этой статьей читают:

Спасибо, что читаешь: SEO HELPER | NICOLA.TOP