Comment faire robots.txt pour wordpress

Bonjour à tous, aujourd'hui je vais dire comment faire robots.txt pour wordpress. Création d'un fichier robots.txt il faut tout d'abord indiquer aux robots des moteurs de recherche quelles sections de votre site le robot peut contourner et indexer et lesquelles non.

Bonjour à tous, aujourd'hui je vais dire comment faire robots.txt pour wordpress. Création d'un fichier robots.txt il faut tout d'abord indiquer aux robots des moteurs de recherche quelles sections de votre site le robot peut contourner et indexer et lesquelles non.

En fait, ce fichier de service est nécessaire pour indiquer au robot de recherche quelles sections du site seront indexées dans les moteurs de recherche et quel robot de recherche doit ignorer. Mais, vous devez comprendre que les robots des moteurs de recherche peuvent ignorer la directive d'interdiction et indexer la section. Cependant, de tels cas sont assez rares.

Le contenu de l'article :

- Création d'un fichier robots.txt

- Décodage du fichier robots.txt (directives)

- Un exemple de fichier Robots.txt étendu pour mon site Web

Robots.txt pour WordPress - comment faire ?

1. Créez un fichier texte appelé robots au format .txt. Créé avec un éditeur de texte standard.

2. Ensuite, saisissez les informations suivantes dans ce fichier :

Agent utilisateur : Yandex Interdire : /wp-admin Interdire : /wp-includes Interdire : /wp-comments Interdire : /wp-content/plugins Interdire : /wp-content/themes Interdire : /wp-content/cache Interdire : / wp-login.php Interdire : /wp-register.php Interdire : */trackback Interdire : */feed Interdire : /cgi-bin Interdire : /tmp/ Interdire : *?s= Agent utilisateur : * Interdire : /wp- admin Interdire : /wp-includes Interdire : /wp-comments Interdire : /wp-content/plugins Interdire : /wp-content/themes Interdire : /wp-content/cache Interdire : /wp-login.php Interdire : /wp- register.php Interdire : */trackback Interdire : */feed Interdire : /cgi-bin Interdire : /tmp/ Interdire : *?s= Hôte : site.com Plan du site : http://site.com/sitemap.xml

3. Remplacez la directive Host: site.com (site.com) par le nom de votre site.

4. Dans la directive Sitemap, indiquez : le chemin complet vers votre sitemap. L'URL peut différer selon le plugin qui génère la carte sur votre site.

5. Enregistrez et téléchargez le fichier robots.txt dans le dossier racine de votre site. Vous pouvez le faire avec n'importe quel client FTP.

6. Parfait, votre fichier est prêt et fonctionne. Désormais, avant de crawler le site, les robots des moteurs de recherche accéderont d'abord à ce fichier de service.

Décodage du fichier robots.txt (directives)

Examinons maintenant le fichier Robots.txt plus en détail. Qu'avons-nous ajouté au fichier robots.txt et pourquoi ?

agent utilisateur - directive, nécessaire pour préciser le nom du robot de recherche. Avec lui, vous pouvez interdire ou autoriser les robots de recherche à visiter votre site. Par exemple:

Nous interdisons au robot Yandex de visualiser le dossier cache :

Agent utilisateur : Yandex

Interdire : /wp-content/cache

Nous autorisons le robot Bing à parcourir le dossier des thèmes (avec les thèmes du site) :

Agent utilisateur : bingbot

Autoriser : /wp-content/themes

Afin que nos règles agissent de manière uniforme pour tous les moteurs de recherche. Utilisez la directive : Agent utilisateur: *

Autoriser et interdire - directive d'autorisation et d'interdiction. Exemples:

Autorisez le bot Yandex à afficher le dossier wp-admin :

Agent utilisateur : Yandex

Autoriser : /wp-admin

Empêchez tous les bots d'afficher le dossier wp-content :

Agent utilisateur: *

Interdire :/wp-content

Ce robots.txt n'utilise pas la directive Allow, ce que nous n'interdisons pas avec la directive Disallow sera autorisé par défaut.

- Hôte - directive, nécessaire pour spécifier le miroir principal du site, il sera indexé par le robot. Tout tiers ne sera pas supprimé.

- Plan du site - ici, nous indiquons le chemin vers le plan du site. Veuillez noter que Sitemap est un outil très important pour la promotion d'un site Web ! Sa présence est essentielle, ne l'oubliez pas.

Un exemple de fichier Robots.txt étendu pour mon site Web

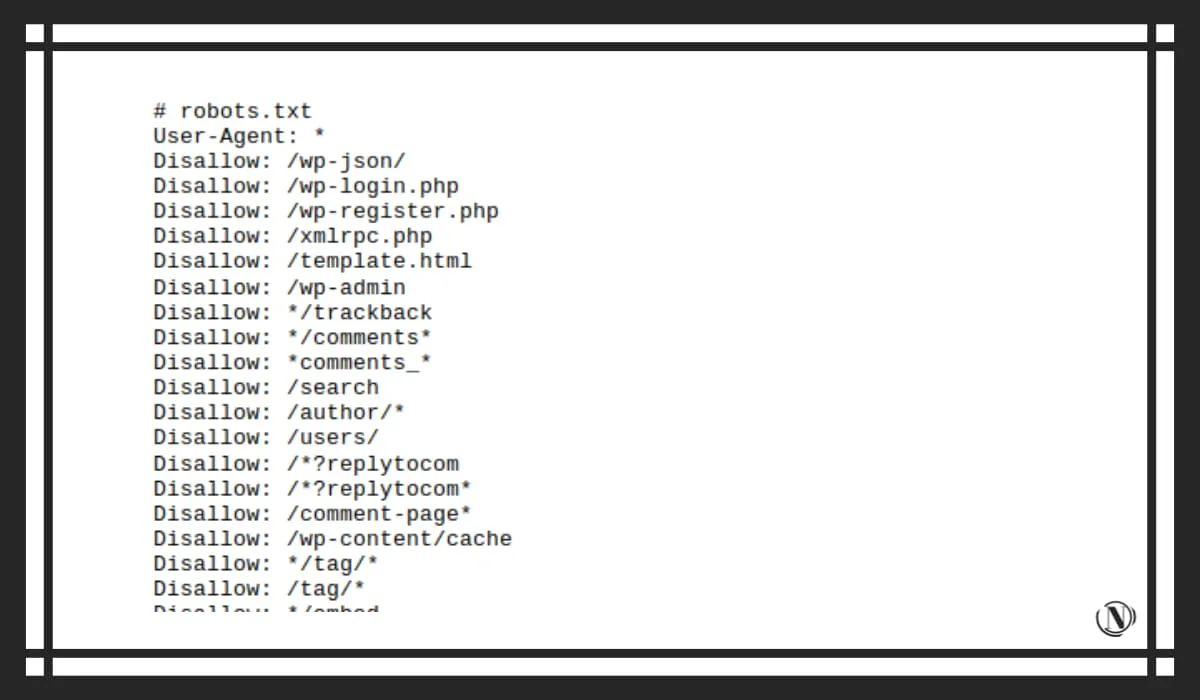

Examinons maintenant le fichier robots de mon site. Veuillez noter que j'édite les directives d'interdiction ou d'autorisation en fonction de mes besoins. Si vous décidez d'utiliser mon exemple, assurez-vous d'examiner le fichier et de supprimer les directives dont vous n'avez pas besoin.

Prenons le fichier robots.txt de ce site :

# robots.txt User-Agent : * Disallow : /wp-json/ # technical information Disallow : /wp-login.php # security Disallow : /wp-register.php # security Disallow : /xmlrpc.php # security, WordPress API file Disallow : / template.html #technical information Disallow : /wp-admin #security Disallow: */trackback #duplicates, comments Disallow: */comments* #duplicates, comments Disallow: *comments_* #duplicates, comments Disallow: /search #web search result pages Disallow : /author /* # pages auteur et utilisateur Interdire : /users/ Interdire : /*?replytocom # snotty index Interdire : /*?replytocom* Interdire : /comment-page* # pages de commentaires Interdire : /wp-content/cache #cache dossier Interdire : */tag /* #tags - le cas échéant Interdire : /tag/* Interdire : */embed$ #all intègre Interdire : */?s=* #search Interdire : */?p=* #search Interdire : */?x= * #search Interdire : */ ?xs_review=* #pages éditeur de publication, aperçu visuel Interdire : /?page_id=* #pages éditeur de page, aperçu visuel Interdire : */feed #all flux et flux rss Interdire : */?feed Interdire : */rss Interdire : *.php #fichiers techniques Interdire : /ads.txt # pages d'annonces techniques, le cas échéant Interdire : */amp # toutes les pages d'ampli - si vous utilisez la technologie, ne pas désactiver. Interdire : */amp ? Interdire : */amp/ Interdire : */?amp* Interdire : */stylesheet #certaines feuilles de style qui sont apparues Interdire : */stylesheet* Interdire : /?customize_changeset_uuid= #doublons techniques du plug-in de mise en cache et de compression Interdire : */?customize_changeset_uuid*customize_autosaved = activé

# précise aux bots les fichiers nécessaires au bon affichage des pages du site. Autoriser : /wp-content/uploads/ Autoriser : /wp-includes Autoriser : /wp-content Autoriser : */uploads Autoriser : /*/*.js Autoriser : /*/*.css Autoriser : /wp-*.png Autoriser : /wp-*.jpg Autoriser : /wp-*.jpeg Autoriser : /wp-*.gif Autoriser : /wp-admin/admin-ajax.php

1TP31Autorisation pour les bots d'afficher des dossiers avec des images Agent utilisateur : Googlebot-Image Allow : /wp-content/uploads/ User-agent : Yandex-Images Allow : /wp-content/uploads/ User-agent : Mail.Ru-Images Allow : /wp-content/uploads/ User-agent : ia_archiver-Images Allow : /wp-content/uploads/ User-agent : Bingbot-Images Allow : /wp-content/uploads/

1TP31 Spécifiez le miroir principal et le sitemap Host : https://nicola.top Sitemap : https://nicola.top/sitemap_index.xml

Conclusion

J'ai expliqué en détail comment créer un fichier robots.txt pour WordPress. Veuillez noter que toutes les modifications apportées à ce fichier seront visibles après un certain temps. Vous pouvez voir l'aperçu le plus complet dans l'article sur la création de robots.txt pour un site sur différents CMS.

Modifiez les directives en fonction de vos besoins. Il n'est pas nécessaire de tout saisir sans réfléchir dans ce fichier de service. De tels changements irresponsables peuvent entraîner la perte et la suppression complète de pages ou de sections importantes du site de la recherche. J'espère que ce guide vous sera utile, assurez-vous de laisser des commentaires avec des questions.

Lire cet article :

- Comment installer Google Analytics sur un site WordPress – Compteur

- Comment rediriger dans WordPress

Merci d'avoir lu : SEO HELPER | NICOLA.TOP