Wiederkehrende neuronale Netze

Wiederkehrende neuronale Netze ist eine Art künstlicher neuronaler Netze, die zur Verarbeitung serieller Daten verwendet werden. Sie unterscheiden sich von anderen Arten neuronaler Netze dadurch, dass sie über Rückmeldungen verfügen, die Informationen über frühere Zustände speichern.

Wiederkehrende neuronale Netze ist eine Art künstlicher neuronaler Netze, die zur Verarbeitung serieller Daten verwendet werden. Sie unterscheiden sich von anderen Arten neuronaler Netze dadurch, dass sie über Rückmeldungen verfügen, die Informationen über frühere Zustände speichern.

Rekurrente neuronale Netze eignen sich für die Arbeit mit Zeitreihen, Texten und anderen Daten, die eine interne Struktur aufweisen. Sie werden beispielsweise zur Spracherkennung, maschinellen Übersetzung und Textstimmungsanalyse verwendet.

Der Hauptvorteil rekurrenter neuronaler Netze besteht darin, dass sie Daten unterschiedlicher Länge verarbeiten. Das bedeutet, dass sie mit Texten unterschiedlicher Länge oder Zeitreihen mit unterschiedlicher Punktanzahl arbeiten können.

Allerdings haben auch wiederkehrende neuronale Netze Schwierigkeiten. Sie erfordern mehr Rechenressourcen und Zeit zum Trainieren als andere Arten neuronaler Netze. Darüber hinaus leiden sie unter dem Problem des Gradientenabfalls, bei dem die Gradienten klein werden und das Training erschweren.

Trotz dieser Komplexität sind rekurrente neuronale Netze ein cooles Werkzeug für die Arbeit mit seriellen Daten und werden in den unterschiedlichsten Bereichen eingesetzt.

Der Inhalt des Artikels:

- Das Funktionsprinzip rekurrenter neuronaler Netze

- Was ist LSTM?

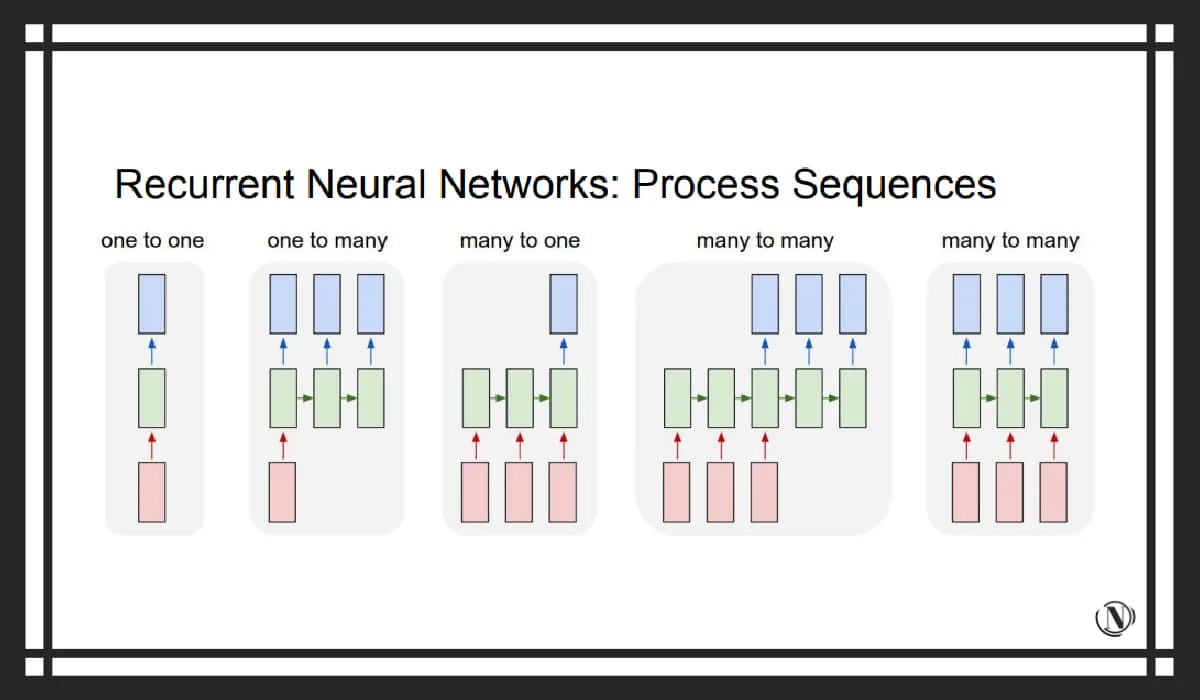

- Arten wiederkehrender neuronaler Netze

- Architektur wiederkehrender neuronaler Netze

- Training wiederkehrender neuronaler Netze

- Beispiele für den Einsatz wiederkehrender neuronaler Netze in der Wirtschaft?

- Welche Unternehmen nutzen rekurrente neuronale Netze?

- Vorteile und Grenzen wiederkehrender neuronaler Netze

- Die Zukunft wiederkehrender neuronaler Netze

- Abschluss

- FAQ

Das Funktionsprinzip rekurrenter neuronaler Netze

Wiederkehrende neuronale Netze (RNN) ist eine Art künstlicher neuronaler Netze, die zur Verarbeitung serieller Daten verwendet werden. RNNs unterscheiden sich von anderen Arten neuronaler Netze dadurch, dass sie über eine Rückmeldung verfügen, die Informationen über frühere Zustände speichert.

Im Gegensatz zu anderen neuronalen Netzen, die jedes Eingabeelement unabhängig verarbeiten, verwenden rekurrente neuronale Netze Informationen über vorherige Zustände, um das aktuelle Eingabeelement zu verarbeiten. Auf diese Weise berücksichtigt RNN den Kontext und verarbeitet Datensequenzen.

Eine fortschrittliche Möglichkeit, wiederkehrende neuronale Netze zu implementieren, ist die Verwendung von Speicherzellen.

Gedächtniszelle ist ein Element eines neuronalen Netzwerks, das Informationen über frühere Zustände speichert. Es verwendet das aktuelle Element und den vorherigen Zustand der Speicherzelle als Eingabe und berechnet auf Grundlage dieser Daten einen neuen Zustand.

Eine beliebte Art von Gedächtniszellen ist LSTM (Langes Kurzzeitgedächtnis). LSTM verfügt über drei Eingangsgatter: ein Eingangsgatter, ein ahnungsloses Gatter und ein Ausgangsgatter. Diese Gatter steuern den Informationsfluss innerhalb einer Speicherzelle, da der LSTM Informationen über langfristige Abhängigkeiten zwischen Sequenzelementen speichert.

Was ist LSTM?

LSTM (Langes Kurzzeitgedächtnis) ist eine Art wiederkehrendes neuronales Netzwerk, das speziell für die Handhabung langfristiger Abhängigkeiten zwischen Sequenzelementen entwickelt wurde. Das LSTM verfügt über eine komplexe Architektur mit drei Eingangstoren: einem Eingangstor, einem ahnungslosen Tor und einem Ausgangstor. Diese Gatter steuern den Informationsfluss innerhalb einer Speicherzelle, da der LSTM Informationen über langfristige Abhängigkeiten zwischen Sequenzelementen speichert.

LSTM wurde entwickelt, um das Problem des Gradientenabfalls zu lösen, der beim Training wiederkehrender neuronaler Netze auftritt. Dadurch kann das Netzwerk langfristige Abhängigkeiten zwischen Elementen einer Sequenz verarbeiten und wird in allen möglichen Bereichen wie Spracherkennung, maschineller Übersetzung und Text-Sentiment-Analyse eingesetzt.

Welche anderen Arten rekurrenter neuronaler Netze gibt es?

Es gibt viele wiederkehrende neuronale Netze. Einige davon sind:

- Netzwerk mit Langzeit- und Kurzzeitgedächtnis (LSTM)

- Verwaltete wiederkehrende Einheit (GRU)

- Vollständig wiederkehrendes Netzwerk

- rekursives Netzwerk

- Hopfield Neuronales Netzwerk

- Bidirektionales Assoziatives Gedächtnis (BAM)

- Elman- und Jordan-Netzwerke

- Echo-Netzwerke

- Kompressor für neuronale Geschichte.

Jeder dieser Typen hat seine eigenen Eigenschaften und wird für verschiedene Aufgaben verwendet.

Architektur wiederkehrender neuronaler Netze

Die Architektur rekurrenter neuronaler Netze (RNN) unterscheidet sich von der Architektur anderer neuronaler Netze durch das Vorhandensein von Rückmeldungen. RNN-Links speichern Informationen über frühere Zustände und verwenden diese zur Verarbeitung des aktuellen Eingabeelements.

Das Hauptelement des RNN ist die Speicherzelle. Die Zelle empfängt das aktuelle Element und den vorherigen Zustand der Speicherzelle als Eingabe und berechnet auf Grundlage dieser Daten einen neuen Zustand. Abhängig von der verwendeten RNN-Architektur gibt es unterschiedliche Arten von Speicherzellen.

- Ein gängiger Speicherzellentyp ist das LSTM (Langes Kurzzeitgedächtnis). Es hat drei Eingangstore: ein Eingangstor, ein Vergessenstor und ein Ausgangstor. Diese Gatter steuern den Informationsfluss innerhalb einer Speicherzelle, da der LSTM Informationen über langfristige Abhängigkeiten zwischen Sequenzelementen speichert.

- Ein weiterer beliebter Speicherzellentyp ist die GRU (Geschlossene wiederkehrende Einheit). Es verfügt über zwei Eingangstore: ein Erneuerungstor und ein Abwurftor. Diese Gatter steuern den Informationsfluss innerhalb einer Speicherzelle, sodass die GRU Informationen über langfristige Abhängigkeiten zwischen Sequenzelementen speichert.

Training wiederkehrender neuronaler Netze

Rekurrente neuronale Netze (RNN) werden mithilfe des Backpropagation-Algorithmus zeitlich trainiert (Rückausbreitung durch die Zeit, BPTT). Dieser Algorithmus ähnelt dem Standard-Backpropagation-Algorithmus, der zum Trainieren anderer neuronaler Netze verwendet wird, weist jedoch einen großen Unterschied auf: Er berücksichtigt die zeitliche Struktur der Daten.

Während des Trainings wird einem RNN eine Folge von Eingaben und eine entsprechende Folge gewünschter Ausgaben präsentiert. Das Netzwerk verarbeitet den Input und berechnet seinen Output. Anschließend wird der Fehler zwischen der gewünschten und der tatsächlichen Netzwerkleistung berechnet.

Dieser Fehler wird dann in der Zeit zurück propagiert, um die Gradienten für jeden Netzwerkparameter zu berechnen. Diese Gradienten werden verwendet, um die Netzwerkparameter mithilfe eines Optimierungsalgorithmus wie dem stochastischen Gradientenabstieg zu aktualisieren.

Das RNN-Training wird jedoch durch das Problem des Verblassens oder Platzens des Gradienten behindert. Dadurch werden die Steigungen kleiner oder größer, was das Training erschwert. Zur Lösung dieses Problems werden Techniken eingesetzt, etwa die Begrenzung der Gradientennorm oder die Verwendung fortschrittlicher Speicherzellentypen wie LSTM oder GRU.

Beispiele für den Einsatz wiederkehrender neuronaler Netze in der Wirtschaft?

Rekurrente neuronale Netze (RNN) werden in der Wirtschaft eingesetzt, um Probleme im Zusammenhang mit der Verarbeitung serieller Daten zu lösen. Einige Beispiele für RNN-Anwendungen sind:

- Zeitreihenvorhersage: RNNs werden verwendet, um Zeitreihen wie Verkäufe, Aktienkurse und Wetter vorherzusagen. Dies kann Unternehmen dabei helfen, fundierte Entscheidungen zu treffen und Aktivitäten zu planen.

- Text-Sentiment-Analyse: RNN wird verwendet, um die Stimmung des Textes zu analysieren und festzustellen, ob die Rezension positiv oder negativ ist. Dies kann Unternehmen dabei helfen, ihr Produkt oder ihre Dienstleistung zu verbessern und die Kundenzufriedenheit zu steigern.

- Maschinelle Übersetzung: RNNs werden für die maschinelle Übersetzung von Texten von einer Sprache in eine andere verwendet. Dies kann Unternehmen dabei helfen, den Markt zu erweitern und mit Kunden in verschiedenen Sprachen zu kommunizieren.

- Spracherkennung: RNNs werden zur Spracherkennung und zur Umwandlung von Sprache in Text verwendet. Dies kann Unternehmen dabei helfen, Sprachschnittstellen zu verbessern und das Kundenerlebnis zu verbessern.

Dies sind Beispiele dafür, wie RNNs zur Lösung alltäglicher Probleme eingesetzt werden. RNNs sind gefragte Werkzeuge zur Verbesserung von Produkten und Dienstleistungen und zur Steigerung der betrieblichen Effizienz.

Welche Unternehmen nutzen rekurrente neuronale Netze?

Rekurrente neuronale Netze werden von Unternehmen zur Lösung verschiedenster Probleme eingesetzt. Zum Beispiel:

- Google nutzt rekurrente neuronale Netze zur Spracherkennung in Produkten wie Google Assistant und Google Translate. Google verwendet sie auch, um Texte maschinell von einer Sprache in eine andere zu übersetzen.

- Amazon nutzt wiederkehrende neuronale Netze, um die Stimmung von Produktbewertungen auf seiner Website zu analysieren. Dies hilft ihnen, die Qualität ihrer Produkte und Dienstleistungen zu verbessern.

- Netflix nutzt wiederkehrende neuronale Netze, um Benutzerinteressen vorherzusagen und Filme und Fernsehsendungen zu empfehlen.

Dies sind drei Beispiele dafür, wie Aggregator-Unternehmen bei ihrer Arbeit wiederkehrende neuronale Netze nutzen.

Vorteile und Grenzen wiederkehrender neuronaler Netze

Rekurrente neuronale Netze (RNNs) haben gegenüber anderen Arten neuronaler Netze eine Reihe von Vorteilen. Der Hauptvorteil von RNN ist die Fähigkeit, serielle Daten zu verarbeiten. Aufgrund des Vorhandenseins von Rückmeldungen speichern RNNs Informationen über frühere Zustände und verwenden diese zur Verarbeitung des aktuellen Eingabeelements. RNNs berücksichtigen also den Kontext und verarbeiten Datensequenzen.

Allerdings weist RNN auch eine Reihe von Einschränkungen auf. Zum Beispiel das Problem des Verblassens oder Explodierens eines Farbverlaufs. Das bedeutet, dass die Steigungen klein oder groß werden können, was das Training erschwert. Zur Lösung dieses Problems werden Techniken eingesetzt, etwa die Begrenzung der Gradientennorm oder die Verwendung fortschrittlicher Speicherzellentypen wie LSTM oder GRU.

Darüber hinaus ist das RNN-Training rechenintensiv, da der Fehler in die Vergangenheit übertragen werden muss. Dies macht es schwierig, RNNs zur Verarbeitung langer Datensequenzen zu verwenden.

Die Zukunft wiederkehrender neuronaler Netze

Rekurrente neuronale Netze (RNNs) sind aufstrebende Forschungsbereiche der künstlichen Intelligenz. Es wird erwartet, dass RNNs in Zukunft zur Lösung äußerst komplexer Probleme im Zusammenhang mit der Verarbeitung serieller Daten eingesetzt werden.

Die Hauptrichtung der Entwicklung von RNNs besteht darin, ihre Fähigkeit zu verbessern, langfristige Abhängigkeiten zwischen Sequenzelementen zu bewältigen. Dies kann durch den Einsatz fortschrittlicher Speicherzellentypen wie LSTM oder GRU oder durch neue Architekturlösungen erreicht werden.

Darüber hinaus sollen neue RNN-Trainingsmethoden entwickelt werden, die es ihnen ermöglichen, große Datenmengen schnell zu verarbeiten. Dies kann den Einsatz von parallelem Rechnen und verteiltem Lernen umfassen.

Die Zukunft von RNN sieht vielversprechend aus. Sie werden weiterhin eine bedeutende Rolle im Bereich der künstlichen Intelligenz spielen und zur Lösung äußerst komplexer Probleme eingesetzt werden.

Abschluss

In diesem Artikel haben wir verschiedene Aspekte rekurrenter neuronaler Netze (RNNs) besprochen. Berücksichtigt werden Funktionsprinzip, Architektur, Anwendung, Vorteile und Einschränkungen sowie zukünftige Entwicklungen.

RNN ist ein wesentliches Werkzeug zur Verarbeitung serieller Daten. Rekurrente neuronale Netze verfügen über eine Rückmeldung, die es ihnen ermöglicht, Informationen über frühere Zustände zu speichern und diese zur Verarbeitung des aktuellen Eingabeelements zu verwenden. Dies ermöglicht es ihnen, kontextbewusst zu sein und Datensequenzen zu verarbeiten.

Allerdings weisen RNNs auch eine Reihe von Einschränkungen auf, wie z. B. das Problem des Gradientenzerfalls oder der Explosion und die hohe Rechenkomplexität des Trainings. Es wird erwartet, dass in Zukunft neue Methoden und Architekturen entwickelt werden, die es RNNs ermöglichen, äußerst komplexe Probleme schnell zu lösen.

FAQ

F: Was sind wiederkehrende neuronale Netze?

A: Recurrent Neural Networks (RNN) ist eine Art künstliches neuronales Netzwerk, das zur Verarbeitung serieller Daten verwendet wird. RNNs unterscheiden sich von anderen Arten neuronaler Netze dadurch, dass sie über eine Rückmeldung verfügen, die es ihnen ermöglicht, Informationen über frühere Zustände zu behalten.

F: Was sind die Vorteile wiederkehrender neuronaler Netze?

A: Der Hauptvorteil wiederkehrender neuronaler Netze ist die Fähigkeit, sequentielle Daten zu verarbeiten. Aufgrund des Vorhandenseins von Rückmeldungen können RNNs Informationen über frühere Zustände speichern und diese zur Verarbeitung des aktuellen Eingabeelements verwenden. Dies ermöglicht es ihnen, kontextbewusst zu sein und Datensequenzen zu verarbeiten.

F: Welche Einschränkungen gibt es bei wiederkehrenden neuronalen Netzen?

A: Eine der Einschränkungen wiederkehrender neuronaler Netze ist das Problem des Gradientenschwunds oder -ausbruchs. Das bedeutet, dass die Steigungen klein oder groß werden können, was das Training erschwert. Außerdem kann das RNN-Training rechenintensiv sein, da der Fehler in die Vergangenheit übertragen werden muss.

F: Welche Beispiele gibt es für den Einsatz wiederkehrender neuronaler Netze in der Wirtschaft?

A: Rekurrente neuronale Netze werden in der Wirtschaft zur Lösung verschiedenster Probleme eingesetzt. Zum Beispiel für Zeitreihenvorhersagen, Textstimmungsanalysen, maschinelle Übersetzung und Spracherkennung. Es kann Unternehmen dabei helfen, Produkte und Dienstleistungen zu verbessern und die Arbeitseffizienz zu steigern.

Lesen dieses Artikels:

- Rekursive neuronale Netze

- Neuronales Netzwerk zum Schreiben von Artikeln: eine neue Ära des Content-Marketings

Danke fürs Lesen: ✔️ SEO HELPER | NICOLA.TOP